Questo è un’estratto dell’articolo “How to Picture A.I.” di Jarod Lanier, pubblicato su newyorker.com il 01/03/2024 e tradotto dalla redazione Around The Century. In questo contenuto Jaron Lanier analizza le meccaniche alla base dell’Intelligenza Artificiale, riflette sulle modalità con cui questa tecnologia è narrata alla società e costruisce un’immagine mentale utile alla sua comprensione.

Articolo originale – PDF articolo tradotto

Una tecnologia da sola non è mai sufficiente. Affinché sia utile essa deve essere accompagnata da altri elementi, quali una comprensione diffusa, buone abitudini associate al suo funzionamento, nonché l’accettazione condivisa delle conseguenze derivanti dal suo utilizzo.

Senza questo tipo di “alone sociale” [societal halo], le tecnologie tendono a essere utilizzate in modo inefficace o incompleto.

Un buon esempio di ciò potrebbero essere i vaccini a mRNA creati durante l’epidemia di Covid. Sono stati una straordinaria conquista medica e tuttavia, a causa di un diffusa incomprensione, non hanno avuto l’impatto che avrebbero potuto avere.

Potrebbe non essere nemmeno corretto chiamare “tecnologia” una tecnologia che non possiede gli elementi necessari per portarla utilmente nel mondo: se non riusciamo a comprendere come funziona, rischiamo di cadere nel pensiero magico.

In altre parole, abbiamo bisogno di una metafora [cartoon] che descriva il funzionamento di una tecnologia. Non so abbastanza sui vaccini per crearne uno per me stesso, ma ho una metafora in testa riguardante i vaccini che me ne fornisce una comprensione approssimativa; è sufficiente per aiutarmi a seguire le notizie sull’argomento, comprendere il loro processo di sviluppo, i rischi e il probabile futuro di questa tecnologia. [..]

Non sono perfette, ma [le metafore] mi forniscono intuizioni sufficientemente buone. Anche gli esperti le usano per parlare tra di loro: a volte una visione semplificata delle cose li aiuta a vedere il quadro generale senza perdersi nei dettagli.

Su questo punto, provo una certa tensione con molti esponenti della mia comunità di scienziati informatici. Credo che le metafore che abbiamo diffuso sull’Intelligenza Artificiale siano controproducenti, ovvero l’abbiamo introdotta nel mondo accompagnata da idee inutili e confondenti.

La parte peggiore è probabilmente il senso di obsolescenza umana e di sventura che molti di noi trasmettono quando parlano di questo argomento. Faccio fatica a capire perché alcuni miei colleghi dicano che quello che stanno facendo potrebbe portare all’estinzione umana e tuttavia sostengano che valga comunque la pena farlo. È difficile comprendere questo modo di fare senza chiedersi se l’A.I. stia diventando effettivamente una nuova forma di religione.

Oltre all’atmosfera apocalittica che stiamo diffondendo, non facciamo nemmeno un buon lavoro nel spiegare cosa sia e come funzioni. […]

Di solito preferiamo trattare i sistemi di Intelligenza Artificiale. come continuità impenetrabili. Forse, in una certa misura, c’è una certa resistenza a demistificare ciò che facciamo perché vogliamo avvicinarci ad esso in modo mistico.

La terminologia abituale, a partire dalla frase “Intelligenza Artificiale” stessa, trasmette l’idea della creazione di una nuova forme di vita piuttosto che di un nuovo strumento.

Questa nozione è rafforzata da termini biologici come “neuroni” e “reti neurali”, e da termini antropomorfizzanti come “apprendimento” o “addestramento”, che gli scienziati informatici usano continuamente.

È anche un problema che “I.A.” non abbia una definizione univoca. […] La mancanza di un ancoraggio vero e proprio del termine coincide con una sensibilità metafisica secondo la quale il quadro umano sarà presto trasceso.

C’è un modo per spiegare l’A.I. che non suggerisca obsolescenza o sostituzione umana? Se possiamo parlare della nostra tecnologia in modo diverso, forse si delineerà un percorso migliore per introdurla nella società. In “There is no A.I.“, un precedente saggio che ho scritto per questa rivista [The Newyorker, ndr], ho discusso la possibilità di considerare l’I.A. come una forma di collaborazione umana anziché come una nuova forma di vita. In questo articolo spero di spiegare come funziona questa Intelligenza Artificiale. senza soffermarmi su dettagli tecnici spesso sconcertanti e enfatizzando invece come la tecnologia modifichi -e dipenda- dal contributo umano. […]

[…]

Possiamo creare la nostra metafora sull’I.A. seguendo a grandi linee quattro passaggi. Ogni passaggio è semplice e ognuno di essi si sommerà in qualcosa di altrettanto facile da immaginare e da usare come strumento di pensiero.

I. Alberi

Il primissimo passo, e in un certo senso il più semplice, è anche il più difficile da spiegare. Possiamo iniziare con una domanda: come si può usare un computer per scoprire se una fotografia ritrae un gatto o un cane? Il problema è che i gatti e i cani sembrano simili per molte caratteristiche. Entrambi hanno occhi e musi, code e zampe, quattro gambe e pelo. È facile per un computer prendere le misure di un’immagine, determinare se è chiara o scura, o per lo più blu o rossa. Ma questo tipo di misurazioni non aiuterà a distinguere un gatto da un cane. […]

A livello tecnico, la risposta è da cercare in un groviglio di sistemi statistici che chiamiamo rete neurale. Ma la prima cosa da capire in realtà è che stiamo trattando con una tecnologia della complessità. […] Quando noi ricercatori sosteniamo che l’I.A. ha “proprietà emergenti” [“emerging properties“] -lo diciamo spesso- intendiamo dire che non sapevamo cosa sarebbe stata in grado di fare finché non abbiamo provato a costruirla. L’Intelligenza Artificiale non è l’unica disciplina a presentare queste caratteristiche: la medicina e l’economia sono molto simili. Anche in questi campi proviamo e riproviamo, scoprendo tecniche che funzionano meglio di altre. Non partiamo da una teoria principale e la utilizziamo per determinare un risultato ideale. Allo stesso modo possiamo lavorare con la complessità, anche se non possiamo prevederla perfettamente.

Proviamo a pensare, con un pò di fantasia, a come distinguere la foto di un gatto da quella di un cane. […]

Un approccio utilizzabile potrebbe essere quello di stendere una griglia di misurazione immaginaria sulla foto, che quantifichi qualcosa di più del suo colore. Per esempio, potremmo iniziare misurando la gradazione con cui i colori cambiano in ogni quadrato della griglia.[…] Uno strato singolo di tali misurazioni non ci aiuterà comunque a distinguere i gatti dai cani. Ma possiamo sovrapporre una seconda griglia alla prima, misurando qualcosa sulla prima griglia, e poi un’altra, e un’altra ancora. Possiamo costruire una torre di strati, il più basso dei quali misura porzioni dell’immagine e ogni strato successivo misura lo strato sottostante. Questa idea di base esiste da mezzo secolo, ma solo di recente siamo stati in grado di farla funzionare bene. […]

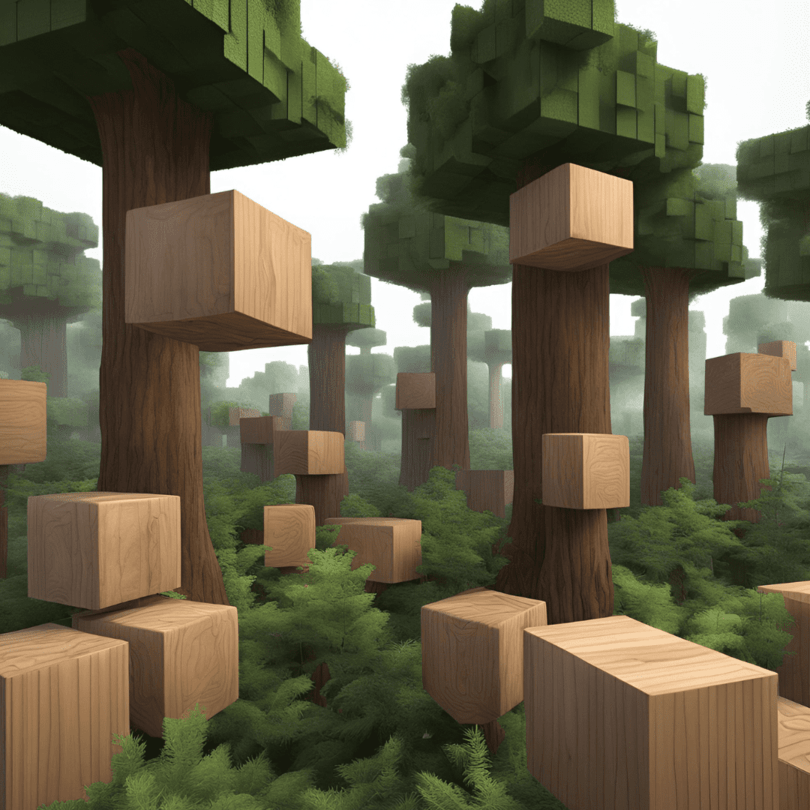

Pensiamo a una struttura fatta di queste griglie come a un grande tronco d’albero che cresce a partire dalla fotografia. (Il tronco è probabilmente rettangolare invece che rotondo, poiché la maggior parte delle fotografie è rettangolare). Dentro l’albero, ogni piccolo quadrato di ogni griglia contiene un numero. Immagina di arrampicarti sull’albero e di radiografarne l’interno, mentre sali sempre più su: i numeri che trovi nelle parti più alte dell’albero dipenderanno dai numeri che stanno più in basso.

Ahimè, ciò che abbiamo ottenuto finora non ci consentirà ancora di distinguere i gatti dai cani. Ma ora possiamo iniziare ad “addestrare” il nostro albero. […] Immagina che la base del nostro albero sia piatta, e che tu possa far scorrere delle immagini sotto di essa. Ora prendi una raccolta di foto di gatti e cani che sono chiaramente e correttamente etichettate come “gatto” e “cane,” e falle scorrere, una alla volta, sotto il suo strato più basso. Le misurazioni si propagheranno verso l’alto fino allo strato superiore dell’albero -il livello della chioma- che potrebbe essere visto da un elicottero.

All’inizio, i risultati mostrati dalla chioma non saranno coerenti. Ma possiamo immergerci nell’albero -con un laser magico, diciamo- per aggiustare i numeri nei suoi vari strati al fine di ottenere un risultato migliore e possiamo potenziare quelli che si rivelano più utili nel distinguere i gatti dai cani. Il processo non è semplice, poiché cambiare un numero su uno strato potrebbe causare una serie di cambiamenti su altri strati. Alla fine, se avremo successo, i numeri sulle foglie della chioma saranno tutti “1” quando c’è un cane nella foto, e saranno tutti “2” quando c’è un gatto.

Ora, incredibilmente, abbiamo creato uno strumento -un albero addestrato-che distingue i gatti dai cani. Gli scienziati informatici chiamano gli elementi della griglia disposti su ogni livello “neuroni” per suggerire un’analogia con i cervelli biologici, ma la somiglianza è piuttosto limitata. Sebbene i neuroni biologici siano talvolta organizzati in “strati,” come nella corteccia, non sempre lo sono; infatti, ci sono meno strati nella corteccia cerebrale rispetto a quelli presenti in una rete neurale artificiale. Con l’I.A., tuttavia, si è scoperto che aggiungere progressivamente strati migliora enormemente le prestazioni, ed è per questo che nella disciplina ricorre spesso il termine “deep,” come in “deep learning”.

È impossibile trovare una metafora perfetta. Nello scrivere questo pezzo, ho provato a usare torri e altre cose alte invece degli alberi, ma la natura organica e familiare agli alberi, nonché il modo in cui crescono riflettendo gli eventi intorno a loro, connettendosi in un grande insieme attraverso il micelio, esprime bene l’idea anche per persone non tecniche. […]

Come vengono addestrati i nostri alberi? La tecnica principale di addestramento si basa su un trucco chiamato “discesa del gradiente” [gradient descent], risalente almeno al 1847, quando il matematico Augustin-Louis Cauchy la descrisse per primo. L’idea di base è di fare una serie di ipotesi sempre migliori su quali numeri nei diversi livelli dell’albero saranno quelli più importanti nel determinare il risultato finale. Il problema è che, non appena un numero inizia a dimostrarsi valido, rischia di diventare troppo prominente, a scapito di altri numeri altrettanto importanti. E’ quindi necessario il giusto equilibrio nel cercare una combinazione fortunata ma imprevedibile di numeri che meritano maggiore rilevanza rispetto ad altri.

Ottenere questo equilibrio implica una serie di compensazioni, necessarie ad evitare la viralità, fenomeno per il quale una cosa diventa sempre più celebre o preziosa, fino all’estremo, semplicemente perché ha iniziato a esserlo al momento giusto. È una coincidenza interessante, perché il mondo umano in senso ampio viene trasformato dalla viralità, e non in modo positivo. […] Usiamo algoritmi di A.I. per dirigere i flussi dei social media verso e tra le persone, per gestire la finanza e molto altro. In tutti questi casi, la viralità è diventata la norma. Ma, all’interno dell’I.A., dobbiamo reprimerla per far funzionare le cose. […]

II. La foresta magica

I gatti e i cani sono facili da immaginare, ma gli stessi principi appena esemplificati possono essere applicati anche ai testi, al codice informatico, alla musica, ai film e a qualsiasi altra cosa. In teoria, possiamo considerare tutto Internet e qualsiasi altro tipo dato che sia possibile ottenere come materiale per costruire alberi addestrati a etichettarli correttamente. Possiamo costruire una foresta magica di questi alberi capaci di riconoscere praticamente qualsiasi cosa in forma digitale.

C’è però un inghippo. È possibile raccogliere foto accuratamente etichettate di gatti, cani e molto altro. Ma la maggior parte delle informazioni prodotte dall’umanità non è stata etichettata in modo così univoco e coerente, e forse non può nemmeno esserlo. Ciò di cui abbiamo bisogno è un approccio che approssimi un sistema di etichette quasi universali. La proprietà che ci permette di farlo è la contiguità. Supponiamo che, su Internet, una certa sequenza di testo tenda a essere situata vicino a un certo tipo di immagine. Questo suggerisce che il testo e l’immagine siano correlati.

Cosa accadrebbe se usassimo il principio di contiguità per stimare le modalità in cui tutto l’universo online risulta essere connesso? In altre parole, cosa succederebbe se usassimo la contiguità come proxy per la semantica? Sarebbe possibile immaginare un’immensa distesa di alberi che emergono da queste associazioni, allungandosi in lontananza, collegati forse da agglomeramenti o da una rete miceliale sotterranea, una grande foresta di classificazione reciproca.

La parola “gatto” appare spesso vicino a immagini di questo animale su Internet, ma gli alberi nella nostra foresta metaforica acquisirebbero un senso di associazione più ampio. Un albero capace di identificare un’immagine di un gatto potrebbe avere radici che lo collegano ad altri alberi che identificano meme sui gatti o letti per gatti. Potrebbe essere collegato ad alberi per giocattoli adorati dai gatti, così come ad alberi capaci di riconoscere le loro malattie […].

I ricercatori stanno cercando di creare modelli di Intelligenza Artificiale. sempre più “multimodali“, in grado di collegare immagini, testi e video in un unico strumento. Questo renderebbe l’I.A. una sorta di modello di concordanza relativo a come l’umanità ha stabilito connessioni tra le cose, almeno nella misura in cui queste cose sono presenti nei dati utilizzati per l’addestramento dell’I.A.

Altrove in questa foresta, alcuni alberi potrebbero essere dedicati alla musica reggaetón, o al codice che gestisce siti Web per fan dei fumetti, o alle immagini radiologiche di tumori ai polmoni. Una foresta abbastanza grande può in teoria classificare praticamente qualsiasi cosa sia rappresentata in forma digitale, dato un numero sufficiente di esempi di quella cosa.

Far crescere una grande foresta è un’impresa stupefacente. Richiede molto tempo e coinvolge risorse straordinarie. Quando il numero accanto a “GPT” aumenta -da 3 a 4, per esempio- ciò segna, tra le altre cose, un nuovo “ciclo di addestramento” in cui cresce una nuova foresta, capace di riconoscere più cose con maggiore affidabilità. Quanto sono grandi queste foreste? Quali cose saranno incluse? Non possiamo saperlo in anticipo.[…]

Foto: Winni Wintermeyer/The Guardian

III. Prodotti della Foresta

Immagina di avere un albero che identifica i gatti, ma nessuna immagine di un gatto. È qui che entra in gioco l’I.A. “generativa”.

È possibile lavorare con una procedura inversa, utilizzando l’albero che riconosce i gatti per creare l’immagine di un gatto.

Inizia con un campo di pixel casuali, un rettangolo di “rumore”. Ora fai scorrere il tuo rettangolo sotto un albero che riconosce i gatti e vedi se riesce a discernere un gatto. Non lo farà, perché l’immagine è costituita solo di pixel casuali. Ora randomizza i pixel casuali. Il risultato ti sembrerà ancora “rumore”, ma nell’albero potrebbe suscitare un debole riconoscimento. Se vedi migliorare il riconoscimento da parte dell’albero, mantieni questo risultato. Se diminuisce, scarta l’ultima modifica. Ora ripeti questo processo più e più volte. Dal “rumore”, alla fine, emergerà un gatto.

[…]

Che gatto hai generato? Non è un gatto reale. Sarà un’interpolazione casuale di alcune immagini di gatti che hanno contribuito all’addestramento dell’albero che riconosce i gatti, incontrato all’inizio del nostro viaggio. I dati di partenza provenivano quindi da immagini di gatti disponibili online, ma la nuova immagine di solito non è esattamente identica a una di quelle. È semplicemente un’immagine che è riconoscibile come “un gatto”.

Esegui di nuovo il processo e otterrai una nuova concatenazione. Addestra un’I.A. a produrre immagini non solo di gatti ma di molte altre cose e avrai una forma base di intelligenza artificiale generativa.

IV. Alberi fantasma

[…] Interagiamo con [i sistemi di I.A. generativa] utilizzando prompt, ovvero combinazioni di parole che descrivono ciò che desideriamo. Le parole nei nostri prompt vengono riconosciute dagli alberi in tutta la foresta. […]

Supponiamo che tu chieda a un sistema di I.A. generativa di produrre “un acquerello di un gatto con un paracadute, che suona una tuba, in procinto di atterrare a Yosemite”. Non ci sono alberi singoli nella foresta che possano esaudire questa particolare richiesta, perché non ci sono mai state immagini su Internet associate a questa specifica combinazione di parole. In un certo senso, ci sono radure che separano gli alberi “acquerello”, “gatto”, “paracadute”, “tuba” e “Yosemite”. Ma attingendo da ogni singolo albero un concetto specifico e producendo qualcosa che sia riconoscibile per tutti gli alberi, un’I.A. può arrivare a colmare il divario. Può evocare un albero fantasma nella radura, fatto su misura per rispondere al tuo prompt.

“Un acquerello di un gatto con paracadute, che suona una tuba, in procinto di atterrare a Yosemite” è un albero interessante. Evocarlo sembra richiedere qualcosa di simile alla creatività. Come esattamente un gatto si adatta a un’imbracatura da paracadute? Come tiene una tuba? […] Attingendo a tutti gli alberi attivati dal prompt, l’ Intelligenza Artificiale troverà una soluzione [tramite] un processo statistico.[..]

Puoi immaginare il programma di I.A. che passa in rassegna tutti gli alberi che corrispondono al prompt e sceglie un’immagine emergente che può essere considerata da tutti gli alberi coinnvolti nel processso come una “corrispondenza”. Su Internet, le immagini di paracadute di solito mostrano persone, non gatti. Ma mettere un gatto in una postura simile a quella di una persona probabilmente può soddisfare i parametri necessari all’albero del paracadute.[…] Il suo output non è perfetto, ma è spesso abbastanza buono per usi concreti o per risultare quantomeno carino.

Alcuni tipi di output possono avere un valore economico. Ad esempio, la foresta potrebbe essere in grado di riconoscere riassunti di documenti contigui alle loro versioni più lunghe […] e poi, in risposta a un prompt, costruire riassunti di documenti che non ha mai visto prima. Come riesce a farlo? […] Le parole tendono a comparire vicino ad altre parole. In questo senso, la prossimità tra parole è simile alla prossimità tra parole e immagini. […] Con abbastanza esempi quindi una foresta di alberi che riconoscono le parole dovrebbe essere in grado di riconoscere se una frase è grammaticalmente corretta e quale autore è più probabile che l’abbia scritta. […]

Generare un testo funziona in un modo un po’ diverso dal generare immagini perché il testo è una sequenza di parole. Invece di concentrarsi su una singola immagine desiderata, un’Intelligenza Artificiale. che lavora con i testi deve scegliere il termine susseguente all’ultimo più e più volte, in relazione non solo al prompt inserito ma anche alle parole scelte in precedenza. […]

Possiamo pensare a ciascun termine come a un singolo punto di incertezza, di rumore, che viene risolto in una scelta di parole, come se fosse un’immagine molto piccola e semplice. Questo è il motivo per cui un processo per molti versi simile a quello che produce l’immagine surreale del gatto con il paracaduta può essere utilizzato per generare il riassunto di un documento qualsiasi.

I dati di addestramento originari dell’I.A. contenevano infatti molti esempi di riassunti e delle loro fonti. Quindi il processo di Intelligenza Artificiale è in grado di generare un elemento di testo che può essere riconosciuto come un riassunto perché metaforicamente attiva gli alberi che originariamente hanno riconosciuto i riassunti, anche se l’argomento trattato nello specifico non è lo stesso che gli è stato fornito durante dell’addestramento. […]

Per i non programmatori, il fatto che le I.A. possano produrre codice può sembrare sorprendente. Ma i programmi per computer sono una forma di testo e i dati utilizzabili per l’addestramento sono abbondanti. La programmazione è spesso estremamente tediosa, perché scrivere un programma implica tener conto di molti dettagli fastidiosi da gestire prima di poter iniziare a lavorare sui propri obiettivi finali. Ma i programmatori hanno già creato milioni di programmi che gestiscono questi dettagli, con lievi variazioni in ogni caso, e hanno pubblicato il proprio codice online.

Proprio come il corpo di un gatto può essere adattato per entrare in un’imbracatura da paracadute, questi programmi preesistenti possono essere leggermente modificati dall’I.A. generativa per adattarsi alle specifiche di un prompt. Secondo alcune stime, l’I.A. generativa può aumentare la produttività dei programmatori del 20-30%, o più.

[…] Gli stessi principi che permettono la generazione di testi e immagini funzionano anche per i video. Recentemente, OpenAI ha annunciato la nasciata di Sora, un sistema di generazione video che può creare clip realistiche a partire da prompt testuali.

Nel mondo fisico, la realizzazione di film spesso richiede una persona addetta alla “continuità”: una figura che si assicura che gli oggetti di scena, le acconciature e le luci non cambino improvvisamente tra una sequenza e l’altra. La continuità è fondamentale perché è ciò che rende la realtà coerente e, in un certo senso, “reale”: è importante che una cosa sembri ancora se stessa anche se esce dall’inquadratura e poi vi rientra. Fino ad ora, gli errori di continuità hanno impedito all’I.A. di creare video convincenti. Se un sistema di generazione di immagini tenta di produrre i fotogrammi di un film, quei fotogrammi finiscono per essere scollegati, con dettagli che non rimangono costanti nel tempo.

Sora approssima la continuità usando un principio semplice. […] In un film, una particolare porzione di immagine in un fotogramma generalmente appare anche nel fotogramma successivo, anche se un pò diversa. Ad esempio, un riflesso sull’occhio di un gatto probabilmente durerà per più di un fotogramma, ma senza rimanere sempre nello stesso punto.

Non è troppo difficile calcolare come, in una serie di fotogrammi, piccoli elementi di una porzione […] possano spostarsi da una posizione all’altra. Una volta analizzato un film in questo modo, è possibile ottenere sequenze di immagini [sweeps] che continuano da un fotogramma all’altro, nel tempo. […]

Un modo per comprendere questa idea ce lo fornisce un passaggio del romanzo “Mattatoio n. 5” di Kurt Vonnegut, che descrive come il mondo appare a una razza di alieni chiamati Tralfamadoriani:

L’Universo non appare come un insieme di piccoli punti luminosi per le creature di Tralfamadore. Le creature possono vedere dove è stata e dove sta andando ogni stella, così che i cieli sono pieni di spaghetti luminosi e rarefatti. E i Tralfamadoriani non vedono nemmeno gli esseri umani come creature a due gambe. Li vedono come grandi millepiedi con gambe di bambini a un’estremità e gambe di anziani all’altra.

Per Sora, questi sweeps sono i blocchi fondamentali, in luogo dei pixel che compongono le immagini statiche. Combinazioni di sweeps di questo tipo sono associate a descrizioni testuali così che, inserendo prompt di testo, gli utenti possono ricombinare gli sweeps in modi nuovi. La generazione di film con questo tipo di modalità restituisce in gran parte il modo in cui le cose si muovono nella realtà, incluso come cambiano le prospettive quando la telecamera si muove e come oscillano i corpi. […] Allo stesso tempo rende comprensibile il motivo per cui le mani sono più inclini a distorcersi in questo processo.

Le mani hanno una loro struttura interna e specifici principi di movimento, il che significa che nel loro flusso di combinazione durante un’intera scena gli sweeps possono facilmente trascurare ciò che sta accadendo nel microcosmo di una mano.

La Linea degli Alberi

Questa tecnologia metterà fuori gioco designer e programmatori? Non credo. Nel caso dei programmatori, continuerà ad esserci una grande domanda di nuovi programmi e aggiornamenti. Ma si può ritenere analogamente che l’I.A. non possa sostituirsi completamente al lavoro di un creativo. Perché no?

Per rispondere a questa domanda dobbiamo considerare sia le potenzialità che i limiti di questa tecnologia. Quando chiedi a un’I.A. di creare un nuovo albero fantasma in risposta a un prompt, introduci di fatto un elemento di novità nel mondo, il che implica una sorta di creatività. Tuttavia, la nostra metafora sull’Intelligenza Artificiale ci suggerisce che si tratta di una creatività limitata: riempie gli spazi tra gli alberi, ma non li supera.

Le menti umane sono così limitate? Oppure possiamo pensare oltre la linea degli alberi di ciò che conosciamo? Un’Intelligenza Artificiale può superare la propria linea degli alberi? I ricercatori sono in disaccordo su queste importanti domande. Al momento, si sa troppo poco sia sui processi umani sia su quelli artificiali per poter affermare qualsiasi cosa con certezza. Nella pratica, tuttavia, dobbiamo necessariamente fare delle assunzioni sul rapporto che andrà a instaurarsi tra persone e macchine mentre introduciamo le macchine nel mondo umano.

Credo che sia meglio presumere che le persone possano raggiungere altezze superiori rispetto agli alberi metaforici di un’I.A. […]

Uno dei problemi delle solite narrazioni antropomorfiche sull’I.A. è che non alimentano le nostre intuizioni relativamente ai suoi punti deboli. Di conseguenza, le nostre discussioni sulla tecnologia tendono spesso a collassare in confronti tra estremi: ci sono entusiasti che pensano che stiamo costruendo un cervello cosmico che risolverà tutti i nostri problemi o ci annienterà, e scettici che non vedono molto valore nell’Intelligenza Artificiale.

Gli scettici spesso si concentrano solo sul nostro terzo passaggio: usare l’I.A. per generare nuovi contenuti che possano essere riconosciuti dai nostri alberi metaforici. Concentrandosi su questo passaggio, la linguista computazionale Emily Bender e i suoi colleghi hanno descritto alcuni modelli come “pappagalli stocastici” [stochastic parrots] che usano le statistiche per riciclare informazioni esistenti. Allo stesso modo, in un saggio per questa rivista [The New Yorker, n.d.r.], Ted Chiang ha sostenuto che l’I.A. generativa crea solo una “rigurgitazione sfocata” [“blurry” regurgitation] dei dati su cui è stata addestrata.

Ho grande rispetto per queste posizioni e sono in una certa misura d’accordo con esse. Ma ciò di cui non tengono conto è il nostro quarto passaggio, ovvero quello in cui viene generato un nuovo albero nella nostra foresta metaforica. Nell’evocare questi alberi, l’I.A. generativa rende esplicite le corrispondenze precedentemente implicite nei dati di addestramento. Dato che non c’è modo di elencarne in anticipo le potenziali combinazioni, possiamo considerare questo processo come creativo. Ma possiamo anche vederne i limiti.

Trovo che l’immagine di un nuovo albero che si alza verso, ma non sopra, il livello definito dalla sommità del fogliame di altri alberi sia utile ed equilibrata. Offre un’alternativa alla visione di un’Intelligenza Artificiale. che non fa altro che rigurgitare, suggerendo al contempo cautela nel considerare la possibilità che l’I.A. diventi una forma di intelligenza trascendente e illimitata. Riempire gli spazi tra gli alberi è fantastico, ma non dovrebbe essere confuso con l’alzare il tetto. Ciò che fa è massimizzare il valore dei dati di addestramento. Questo, di per sé, è una ragione sufficiente per essere entusiasti dei progressi più recenti dell’I.A.

Il Valore della Foresta

La Big-model I.A. sfrutta dati esistenti. Le sue foreste crescono sfruttando le somiglianze con compiti ripetitivi che prima erano eseguiti dalle persone. Attraverso l’Intelligenza Artificiale., recuperiamo parte del valore che queste persone hanno creato. Questo vale per lo sviluppo di programmi, il riassunto di documenti, la creazione di corsi, il disegno di immagini di gatti e così via. Possiamo pensare all’Intelligenza Artificiale come a un metodo per rendere il passato più presente negli sforzi umani di oggi, aumentandolo.

Sfruttare lo sforzo umano in modi nuovi e migliori è la stessa definizione di valore economico. Questo è un buon principio di partenza che manager, investitori e clienti dovrebbero tenere a mente. Se vuoi capire dove l’I.A. generativa porterà maggior valore, chiediti: quali attività umane sono state svolte molte volte prima, ma non esattamente nello stesso modo? In questi ambiti, l’I.A. generativa può probabilmente migliorare la situazione.

Navigare nella foresta

Le persone hanno preoccupazioni legittime riguardo all’I.A., preoccupazioni relative alla sua sicurezza, qualità, equità e impatto economico. La metafora che abbiamo creato in questo articolo può anche aiutarci a comprendere il lavoro di coloro che cercano di affrontare queste preoccupazioni. Vista da lontano, questa metafora crea un trittico: al centro, tra i dati di addestramento da un lato e i risultati generativi dall’altro, si estende una vasta e strana foresta. I dati di addestramento e i risultati sono intelligibili, nel senso che le persone possono capirli. La parte centrale, la foresta, resterà però […] per lo più inintelligibile.

Un passo che i ricercatori hanno compiuto, con effetti positivi, è stato quello di iniziare a pattugliare le parti intelligibili, ovvero i prompt e i relativi risultati. I sistemi di Intelligenza Artificiale di oggi includono “barriere di sicurezza” che limitano i prompt che i loro sviluppatori considerano potenzialmente dannosi. Si sta lavorando anche per ridurre l’impatto dei dati di addestramento considerati peggiori, così che escludendo quelli esplicitamente criminali, falsi, dannosi o di parte, sia possibile far crescere una foresta più sana.

Possiamo rendere la foresta stessa, il “centro” del trittico, più navigabile? In “There Is No A.I.” ho sostenuto che dobbiamo capire come tracciare le connessioni tra input e output specifici nei grandi modelli di IA. Questo equivarrebbe al lasciare briciole di pane nella la foresta mentre essa continua a crescere. Ciò è fattibile nella teoria, ma non ancora nella pratica e credo sia importante capire come realizzarlo.

Supponiamo che un gruppo di malintenzionati voglia arruolare un’I.A. per costruire una bomba. Potrebbero essere abbastanza astuti da evitare di usare la parola “bomba” in un prompt. Potrebbero persino essere in grado di chiedere un output camuffato: magari c’è un modo per indurre un’I.A. a creare una ricetta per una torta che risulta essere esplosiva. Ma il loro compito sarebbe molto più difficile se il loro operato lasciasse tracce nella foresta. A un certo punto, il sentiero porterebbe a un documento correlato a una bomba nei dati di addestramento.

Alcuni sviluppatori e utenti di intelligenza artificiale potrebbero obiettare che sto sottovalutando la tecnologia, ma non sono d’accordo. Essere in grado di affermare il valore concreto e finito di qualcosa potrebbe danneggiare la fantasia di un suo potenziale infinito, ma alla fine ci offrirebbe una percezione più concisa e pratica del valore di quella cosa. Altri noteranno che la tecnologia è sempre in movimento: la versione di I.A. che ho descritto qui potrebbe presto essere sostituita da qualcosa di diverso, rendendo la nostra metafora obsoleta. Forse sarà così. […]

Nonostante ciò, la nostra metafora è una descrizione ragionevolmente corretta di ciò che esiste oggi. Questo fa parte del suo valore. Cattura i poteri e i limiti della tecnologia I.A. così com’è, non come alcuni ricercatori vorrebbero che fosse. Se la versione di Intelligenza Artificiale descritta qui diventasse obsoleta, se la foresta venisse abbattuta, chiunque si presentasse successivamente sarebbe obbligato a fornire una nuova metafora valida, insieme a tutti gli altri elementi umani necessari affinché la nuova tecnologia sia una vera tecnologia.

Lo scrittore di fantascienza Arthur C. Clarke ha dichiarato che una tecnologia sufficientemente avanzata è indistinguibile dalla magia. Ma questo è vero solo se quella tecnologia non è spiegata abbastanza bene. È responsabilità dei tecnologi assicurarsi che le proprie creazioni non siano considerate alla stregua di strumenti magici.

©2024 Jaron Lanier – The New Yorker

Vedi la biografia di Jaron Lanier